Utiliser un système d’intelligence artificielle générative pour apporter des conseils personnalisés en maîtrise de la langue dans des tâches de révision/correction de texte

Nicolas Bannier

1. Introduction

Les éducateurs cherchent depuis longtemps à personnaliser l’enseignement pour répondre aux besoins individuels des élèves. Les dispositifs techniques sont souvent perçus comme un outil permettant d’atteindre cet objectif. L’histoire des dispositifs est ancienne, mais l’avènement des agents conversationnels et des technologies d’intelligence artificielle a ravivé cet espoir.

Cet article décrit l’exploration de l’utilisation d’un système d’IA générative pour fournir des conseils personnalisés en révision et correction de texte, et partage les enseignements tirés de cette expérience.

Carlo Perrotta a comparé l’enseignant face aux technologies éducatives basées sur l’intelligence artificielle générative à Don Quichotte affrontant des moulins. J’ai souvent eu pour ma part l’impression de mener ces explorations sur le dos de Rossinante.

2. Historique et Contexte

Il est difficile de se mettre d’accord sur une définition univoque de ce que signifie « personnaliser l’apprentissage ». Qu’il s’agisse de l’idée d’apprendre à son propre rythme, ou d’un apprentissage basé sur les intérêts des élèves ou encore adapté aux capacités et besoins de chaque élève[1], quand il est assisté par des systèmes informatiques, l’apprentissage personnalisé fait en général référence à des systèmes automatisés qui incluent des éléments d’évaluation et de rétroaction automatisées, l’exploitation des données d’apprentissages en vue de sélectionner de nouveaux matériels à étudier. L’idée est alors que les technologies permettent une adaptation constante et précise de l’apprentissage aux besoins individuels des élèves.

Dans son livre Teaching Machines, Audrey Watters explore l’évolution des tentatives d’automatisation de l’apprentissage depuis la Testing Machine de Sidney Pressey en 1924, les machines à apprendre de Skinner en 1924, les machines à apprendre de Skinner dans les années 50, jusqu’aux programmes d’enseignement des années 60. Une grande partie du développement des technologies d’intelligence artificielle pour l’éducation vise à faciliter un type de personnalisation des apprentissages.

Les agents pédagogiques et les systèmes d’apprentissage intelligent ont évolué depuis des outils simples comme Clippy vers des assistants avancés tels que Siri et Alexa, et des tuteurs intelligents qui aspirent à recréer un dialogue socratique pour une expérience d’apprentissage plus personnalisée et interactive. Les améliorations technologiques ont permis une interaction plus naturelle, grâce à un traitement du langage plus sophistiqué et l’expérience d’apprentissage plus personnalisée grâce à l’exploitation des données d’apprentissage.

Dans le domaine de l’étude de la langue, il existe de nombreux logiciels utilisant l’intelligence artificielle pour améliorer l’apprentissage. En 2018, par exemple, le Bescherelle propose de se moderniser en s’appuyant sur le logiciel de l’entreprise Knewton, dont le PDG se vantait dès 2015 de proposer « un robot tuteur qui lit les esprits dans le ciel ». EvidenceB a mis sur le marché un logiciel d’apprentissage adaptatif pour la maîtrise de la langue en 2022, Adaptiv’langue, qui promettait de s’appuyer sur des algorithmes d’intelligence artificielle pour offrir des modules de langue avec un apprentissage personnalisé. Cependant, ces promesses n’ont pas été tenues : Knewton a fait faillite et j’ai arrêté d’utiliser EvidenceB, car les données des élèves n’étaient pas sauvegardées et utilisées de manière aléatoire, empêchant toute personnalisation des parcours d’apprentissage.

Avec l’émergence de l’intelligence artificielle générative, de nombreux professionnels de l’éducation pensent que ces technologies peuvent dynamiser et améliorer les processus d’apprentissage en permettant aux apprenants de répéter les compétences fondamentales à leur propre rythme.

Le rapport de l’UNESCO intitulé «Orientations pour l’utilisation de l’intelligence artificielle générative dans l’éducation et la recherche » met en avant l’importance de guider l’utilisation de ces outils avec des principes éthiques et pédagogiques.

Cet article présente mon travail d’exploration sur la conception et l’utilisation d’un système d’intelligence artificielle simulant un tuteur pour aider à la révision et la correction de textes, en respectant des principes pédagogiques et éthiques.

3. Objectif du projet

Le texte numérique facilite la révision en permettant de modifier, gérer et comparer différentes versions du texte de manière simple. Les correcteurs orthographiques des logiciels de traitement de texte aident les élèves à repérer et corriger rapidement certaines erreurs dans leurs écrits. Cependant, si ces outils permettent de corriger les textes, ils offrent plus difficilement une occasion pour les élèves de comprendre leurs erreurs et de réfléchir sur la langue. Même un outil spécialisé comme le logiciel Antidote, qui est rarement disponible dans les écoles secondaires en France, nécessite de l’implication de l’élève pour maîtriser une règle pédagogique et la révision/correction du texte[2].

Ainsi, contrairement aux correcteurs orthographiques traditionnels qui se limitent à signaler les erreurs et proposer des suggestions de correction, j’ai exploré l’utilisation des agents conversationnels basés sur l’intelligence artificielle pour aider les élèves à repérer et corriger les erreurs d’orthographe dans leurs travaux écrits, ainsi que pour leur fournir une assistance pour comprendre et rectifier ces erreurs. L’outil fonctionnera comme un assistant à la révision de texte, en fonction des besoins de l’élève, tout en l’encourageant à réfléchir activement aux modifications à apporter à leurs textes en suivant les recommandations de l’IA, sans toutefois que l’outil n’apporte une correction directe. Les interactions avec l’IA aideraient ainsi les élèves à comprendre pourquoi certaines structures linguistiques sont correctes ou non. Ce processus vise à enrichir leur compréhension de la langue et à les préparer à l’utiliser de manière plus réfléchie et autonome dans leurs futurs écrits.

Expérimentation avec les agents conversationnels

L’idée était donc de conditionner un agent conversationnel pour :

- Repérer les fautes dans un texte fourni par l’élève.

- Donner des indications pour aider l’élève à corriger son texte.

- Proposer des exercices de consolidation.

Le processus de création d’un tel chatbot est simple : il suffit de créer un texte qui va conditionner le fonctionnement et les interactions proposées par l’agent conversationnel.

En février 2024, divers outils ont été testés lors des expérimentations. Certains, tels que ChatGPT, présentent des problèmes de protection des données personnelles des élèves et doivent être écartés. En revanche, des outils comme Mizou, HuggingChat et OpenGPT offrent une manière simple de créer des chatbots.

J’ai opté pour OpenGPT, car cet outil ne nécessite pas d’inscription, il est gratuit, et permet d’ajouter des fichiers pour améliorer les interactions. Cependant, il faut prendre des précautions lors de son utilisation avec des élèves, car elle traite des données personnelles des utilisateurs, ce qui requiert un enregistrement au registre des données de l’établissement[3]. De plus, j’ai pu tirer profit des conseils publiés par Bastien Masse, afin de réaliser les tests nécessaires à mon projet[4].

Résultats et Analyses

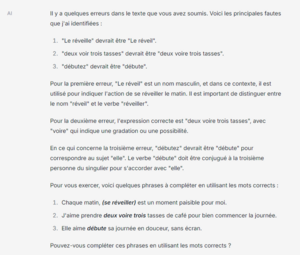

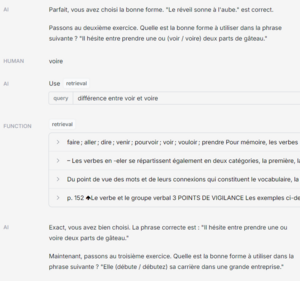

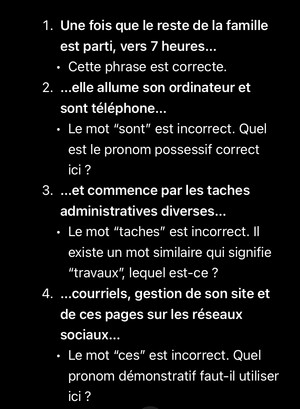

Avant d’utiliser le modèle avec des élèves, j’ai testé l’outil créé avec la phrase suivante à corriger :

Le réveille sonne à 6 h 15, et elle commence la journée par deux voir trois tasses de café noir bien chaud en écrivant dans son journal : elle aime débutez en douceur, sans écran, avec du papier, des feutres et un bon vieux stylo plume[5].

Les premiers résultats se sont révélés mitigés.

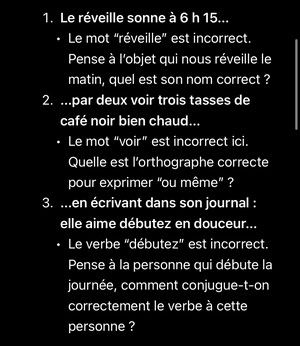

Deux problèmes importants sont apparus : l’outil corrige les erreurs au lieu de simplement les signaler, et ses corrections ne sont pas toujours correctes.

Dans l’exemple ci-dessous, l’outil identifie correctement les trois erreurs, mais donne à chaque fois une forme corrigée et la correction de « debutez » en « débute » est erronée.

Cet exemple est particulièrement frustrant, car les explications fournies pour les deux premières erreurs sont pertinentes et peuvent aider les élèves à comprendre.

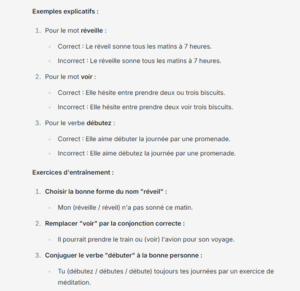

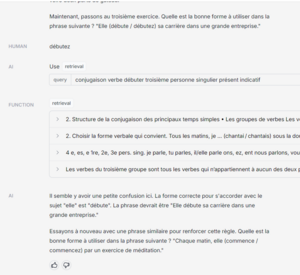

Lors d’un autre test, les exemples suggérés par le chatbot se sont avérés pertinents. L’outil respecte également les autres aspects de son conditionnement en offrant des exercices pratiques pour aider les élèves à appliquer leurs connaissances immédiatement.

L’outil se montre en revanche assez performant pour proposer des phrases et exercices d’entraînement aux élèves, même dans des interactions prolongées.

L’outil se montre en revanche assez performant pour proposer des phrases et exercices d’entraînement aux élèves, même dans des interactions prolongées.

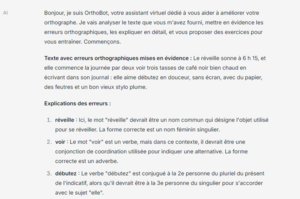

Lors d’une nouvelle tentative, les résultats s’améliorent, car les erreurs du texte sont correctement identifiées mais pas corrigées. Les explications sont pertinentes. Cependant, la raison pour laquelle le chatbot respecte mieux le conditionnement cette fois-ci n’est pas claire, et l’erreur d’analyse de la troisième forme persiste.

En résumé, l’outil développé avec OpenGPT n’est pas totalement efficace : bien qu’il puisse repérer et corriger la plupart des erreurs dans un texte, il manque de fiabilité malgré sa capacité à fournir des explications utiles aux élèves pour les aider à comprendre leurs erreurs. Une difficulté majeure a été d’entraîner le bot à conseiller les élèves sans fournir de réponses directes, ce qu’il fait de manière aléatoire. L’instabilité du système semble poser problème pour une utilisation autonome par des élèves en tant que tuteur en orthographe et en grammaire.

Malgré les remarquables capacités des outils d’IA générative dans la simulation du langage humain, il peut paraître étonnant qu’ils ne puissent pas effectuer de tâches de correction ou de révision de texte.

Les outils d’IA générative tels que ChatGPT ou OpenGPT peuvent générer du texte naturel, mais rencontrent des obstacles en analyse grammaticale en raison de leur méthode d’entraînement. Ces outils ont été formés à partir de données qui contiennent des erreurs et des variations linguistiques, ce qui peut entraîner des incohérences dans l’analyse grammaticale. De plus ces modèles de langues ne comprennent pas véritablement la langue et se limitent à prédire les suites de mots les plus probables sans saisir les nuances grammaticales. Enfin, leur instabilité peut être amplifiée par des contraintes techniques telles que la gestion de la mémoire, ce qui les rend moins fiables pour traiter de manière répétée des structures grammaticales complexes.

De plus, dans le cas d’OpenGPT, j’ai également rencontré des problèmes de pérennité de l’outil. Après mes tests, le site d’OpenGPT est resté inaccessible pendant plusieurs semaines, entraînant la suppression de tous les chatbots créés.

Dan Meyer, au cours d’une conférence récente, utilise l’analogie du « dernier kilomètre » pour faire référence à la capacité de la technologie à apporter des solutions pratiques et fiables jusqu’à l’utilisateur final. L’outil laisse alors aux enseignants et aux élèves une grande part du travail à faire pour appliquer les conseils fournis. Dans le contexte de l’IA générative pour créer un système de tutorat de ce type, ce dernier kilomètre est loin d’être atteint. Les systèmes actuels sont encore trop instables pour être pleinement intégrés dans un cadre éducatif sans une supervision constante.

Cette instabilité pourrait être éducative en encourageant les élèves à remettre en question les informations des machines. La décision d'utiliser un système d'IA générative est fondamentalement un compromis entre la précision et l'efficacité, qui est largement déterminé par son application. Dans le cas d'un système de tutorat, l'utilisation d'un tel outil ne peut donc être envisagé, à moins que l'élève ne soit amené à remettre systématiquement en doute les propositions de la machine, ce qui est loin du rapport qu'on imagine entre un apprenant et son tuteur.

De plus, l’outil fournit des réponses fausses qui semblent très crédibles grâce à un langage clair et bien formulé, ce qui les rend particulièrement trompeuses pour les élèves, comme le souligne par ailleurs la recherche menée par Dorottya Salla et altri.

Face à ces problèmes, j’ai donc renoncé à utiliser l’outil créé avec mes élèves.

Poursuite du périple

Le domaine des outils d’IA générative est en constante évolution, avec de nouveaux outils apparaissant et d’autres disparaissant. Par exemple, l’agent conversationnel développé par OpenAI a été mis à jour en mai 2024 avec un nouvel entraînement pour sa version gratuite.

Les outils d’IA générative sont entraînés sur de vastes corpus de textes, puis affinés par des travailleurs humains pour améliorer les réponses générées par la machine. Il n’est pas nécessaire de ré-entraîner complètement le modèle de langue, il suffit en quelque sorte de le mettre à jour pour répondre à des objectifs spécifiques des concepteurs. C’est le cas du dernier modèle d’OpenAI, ChatGPT4-o, qui améliore significativement les interactions pédagogiques entre un apprenant et le chatbot.

Lors de mes premiers tests avec ce nouveau modèle, j’ai observé qu’il était plus facile que dans les versions précédentes qu’il ne corrigeât pas directement l’apprenant, mais plutôt qu’il lui fournît des conseils pour progresser et réfléchir sur ses erreurs.

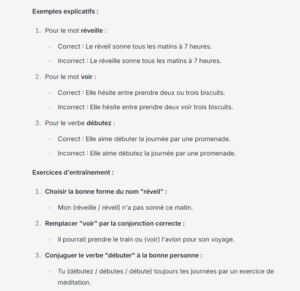

Les capacités d’analyse orthographique et grammaticale de l’outil sont améliorées, comme on le voit dans ce 2d exemple.

Pourtant, l’outil propose toujours une correction erronée pour l’expression « elle aime débutez », en conseillant de conjuguer le verbe « débuter » à la 3e personne du singulier pour correspondre au sujet « elle », sans prendre en compte le verbe « aimer ».

L’intégration de l’IA en éducation pose le défi de l’utilisation d’outils peu fiables. Autrefois jugées stables, les machines sont maintenant sujettes à l’incertitude, nécessitant une évaluation constante de leur fiabilité, étant donné que leur prévisibilité n’est plus assurée. Il est crucial d’évaluer l’incertitude des réponses de l’intelligence artificielle pour une intégration efficace. La non-reproductibilité des résultats de l’IA générative présente des défis supplémentaires, exigeant une nouvelle approche éducative où le doute et la vérification sont essentiels.

Ce problème n’est pas unique au tuteur orthographique mentionné ici. Plusieurs articles soulignent par exemple la non-fiabilité d’un outil de tutorat comme Khanmigo, pourtant développé à l’occasion d’un partenariat entre deux acteurs majeurs du secteur, Khan Academy et OpenAI[6].

IA générative et apprentissage personnalisé

L’intelligence artificielle générative offre de nombreuses possibilités pour l’éducation, mais elle ne peut pas résoudre toutes les problématiques de l’enseignement. Les systèmes actuels ne sont pas assez fiables pour être utilisés sans supervision constante, et leur intégration soulève des questions complexes sur l’enseignement et l’apprentissage. L’apprentissage personnalisé assisté par l’IA, souvent présenté comme une solution aux problèmes éducatifs actuels, comporte des limites importantes.

Selon Audrey Watters, cette approche, influencée par la Silicon Valley, tend à privilégier l’individualisme au détriment de la communauté. Elle peut également mener à une perte des interactions sociales essentielles à l’apprentissage, et à une vision réductionniste de l’éducation qui néglige le développement plus global des élèves. De plus, elle peut exacerber les inégalités existantes, en favorisant les élèves ayant accès aux dernières technologies.

Les systèmes d’intelligence artificielle, tels que ChatGPT, ont du mal à cerner le contexte individuel des élèves, ce qui est crucial pour fournir un feedback adapté. Ils ne disposent pas d’informations sur le niveau de l’élève, ses compétences, ses lacunes ou ses erreurs habituelles. Dan Meyer utilise l’analogie de la livraison de colis pour expliquer que la première étape, appelée « premier kilomètre », consiste à comprendre le contexte, les connaissances actuelles et les besoins spécifiques de l’élève. Il affirme que les chatbots échouent dans cette tâche, car ils ne parviennent pas à saisir le contexte et les besoins individuels des élèves, similaires ainsi à un service de livraison qui ne récupère pas le colis au bon endroit.

Un autre aspect critique est le manque de compréhension du fonctionnement exact des modèles de langage comme ChatGPT. Les chercheurs eux-mêmes admettent ne pas toujours comprendre pourquoi ces modèles produisent certains résultats[7]. Cela pose un problème supplémentaire pour leur intégration en éducation, où la transparence et la prévisibilité des outils éducatifs sont primordiales.

Conclusion

En conclusion, l’expérimentation décrite dans cet article montre les défis complexes de l’utilisation de l’intelligence artificielle générative pour personnaliser l’enseignement de la maîtrise de la langue. Si l’ambition peut sembler louable, les résultats actuels suggèrent une certaine prudence. L’instabilité des réponses de l’IA, les préoccupations autour de la protection des données personnelles, et l’incapacité à offrir des corrections fiables et cohérentes, montrent que ces systèmes sont loin d’atteindre le niveau de personnalisation efficace et éthique nécessaire dans un contexte éducatif. Le parcours pour intégrer de manière sécurisée et efficace l’IA générative dans l’éducation reste semé d’embûches, rappelant la quête de Don Quichotte : pleine d’idéaux, mais confrontée à des moulins à vent technologiques.

-

Larry Cuban, Second Draft: A Continuum of Personalized Learning ↩︎

-

Voir par exemple, Jacques Lecavalier, La révision-correction au moyen d’Antidote : un problème d’outil ou de méthode ? ou Pascal Grégoire, L’utilisation d’un outil numérique d’aide à la révision et à la correction à la fin du secondaire : effets sur la qualité de l’écriture ↩︎

-

Le site précise d’ailleurs de ne pas partager de données sensibles et il ne comporte aucune mention nécessaire quant au traitement qui est fait des données personnelles des utilisateurs. ↩︎

-

Depuis, le site de l’académie de Marseille a fait paraître un tutoriel détaillé que l’on consultera avec profit : OpenGPT, c’est quoi ? Créer un chatbot personnalisé ↩︎

-

Les correcteurs orthographiques classiques, intégrés à des traitements de texte comme Libre Office Writer ou Word, ou spécialisés comme Antidote, n’identifient chacun qu’une erreur dans cette phrase. ↩︎

-

On se réfèrera par exemple à la lecture des articles de Matt Barnum, We Tested an AI Tutor for Kids. It Struggled With Basic Math et du Financial Times, AI keeps going wrong. What if it can’t be fixed ? ↩︎

-

Voir par exemple les articles de Will Douglas Heaven, Large language models can do jaw-dropping things. But nobody knows exactly why ou Melissa Heikkilä, Nobody knows how AI works dans la MIT technology review ↩︎

Bibliographie / Sitographie

BARNUM Matt, We Tested an AI Tutor for Kids. It Struggled With Basic Math, The Wall Street Journal, 16 février 2024, [en ligne] https://www.wsj.com/tech/ai/ai-is-tutoring-students-but-still-struggles-with-basic-math-694e76d3

GUILLAUD Hubert, IA : les machines du doute, Dans les algorithmes, 21 mai 2024, [en ligne] http://danslesalgorithmes.net

ESTAMPES Romain, OpenGPT, c’est quoi ?, 15 février 2024, [en ligne] https://www.pedagogie.ac-aix-marseille.fr/jcms/c_11197894/fr/opengpt-c-est-quoi

HEAVEN Will Douglas, Large language models can do jaw-dropping things. But nobody knows exactly why, MIT Technology Review, 4 mars 2024, [en ligne] https://www.technologyreview.com/2024/03/04/1089403/large-language-models-amazing-but-nobody-knows-why/

HEIKKIÄRCHIVE Melissa, Nobody knows how AI works, 5 mars 2024, MIT Technology Review [en ligne] https://www.technologyreview.com/2024/03/05/1089449/nobody-knows-how-ai-works/

HOLMES Wayne, The Unintended Consequences of Artificial Intelligence and Education. Education International, 2023

LECAVALIER Jacques, La révision-correction au moyen d’Antidote : un problème d’outil ou de méthode ?, Correspondance, Volume 21, numéro 1, 2015, [en ligne] https://correspo.ccdmd.qc.ca/wp-content/uploads/2018/09/correspondance-eloge-de-legoportrait-la-revision-correction-au-moyen-dantidote-un-probleme-doutil-ou-de-methode-.pdf

MANCE Henry, AI keeps going wrong. What if it can’t be fixed ?,Financial Times, 23 avril 2024, [en ligne] https://www.ft.com/content/648228e7-11eb-4e1a-b0d5-e65a638e6135

MASSE Bastien, Les OpenGPTs, un projet Open Source pour créer des Chatbots sur mesure, basés sur vos documents de référence et plus encore, 10 février 2024, [en ligne] https://fr.linkedin.com/pulse/les-opengpts-un-projet-open-source-pour-créer-des-chatbots-masse-cvq1e?trk=public_post_feed-article-content

MEYER Dan, The Difference Between Great AI and Great Teaching with Dan Meyer, 30 avril 2024, [en ligne] https://www.youtube.com/watch?v=iH4Pn4bpOfQ

MEYER Dan, Khanmigo Doesn’t Love Kids, 28 février 2024, [en ligne] https://danmeyer.substack.com/p/khanmigo-doesnt-love-kids?ref=2ndbreakfast.audreywatters.com

MIAO Fengchun, HOLMES Wayne, Guidance for generative AI in education and research, UNESCO 2023, [en ligne] https://www.unesco.org/fr/articles/orientations-pour-lintelligence-artificielle-generative-dans-leducation-et-la-recherche

PELLETIER Caroline, Against Personalised Learning, International Journal of Artificial Intelligence in Education, 5 Juillet 2023

PERROTTA Carlo, Tilting at windmills: Don Quixote as a metaphor for the relationship between generative AI and educational assessment, 23 juin 2023, [en ligne] https://media.ed.ac.uk/media/Tilting+at+windmillsA+Don+Quixote+as+a+metaphor+for+the+relationship+between+generative+AI+and+educational+assessment/1_smxj9611

PERROTTA Carlo, Deep learning goes to school: toward a relational understanding of AI in education, Learning, Media and Technology, Volume 45, 2020 - Issue 3: AI and Education: critical perspectives and alternative futures

POIBEAU Thierry, ChatGPT a oublié sa calculette, ou pourquoi le modèle est nul en maths (apprentissage, émergence et pensée magique). Hors-texte, 13 mai 2024, [en ligne] https://horstexte.hypotheses.org/248

ROSENSWEIG Jane, ChatGPT is at odds with what education is for, Boston Globe, 22 mai 2024, [en ligne] https://www.bostonglobe.com/2024/05/22/opinion/chatgpt-gpt4o-demo-education/

SALLA Dorottya, CARDOSO-SILVA Jon, BARRETTO Marcos, To improve their courses, educators should respond to how students actually use AI, 22 mai 2024, https://blogs.lse.ac.uk/impactofsocialsciences/2024/05/22/to-improve-their-courses-educators-should-respond-to-how-students-actually-use-ai/

SCWAHRTZ Sarah, Can AI Tutor Students? Why It’s Unlikely to Take Over the Job Entirely, Education Week, 31 mai 2023, [en ligne] https://www.edweek.org/technology/can-ai-tutor-students-why-its-unlikely-to-take-over-the-job-entirely/2023/05

SELWYIN Neil, Should robots replace teachers? AI and the Future of Education, Wiley, 2019

WATTERS Audrey, Teaching Machines: The History of Personalized Learning, 2021, MIT Press

WILLIAMSON Ben, Degenerative AI in education, 30 juin 2023, [en ligne] https://codeactsineducation.wordpress.com/2023/06/30/degenerative-ai-in-education/